29. Oktober 2024 von Milena Fluck und Daniel van der Wal

Kreativität: Kognition und GenAI - Teil 3

„I never made one of my discoveries through the process of rational thinking.”

Albert Einstein

Sei es durch verstärktes oder überwachtes Lernen. Seit Jahren versuchen wir, virtuelle Agenten dazu zu bringen, zu lernen, rational zu handeln und optimale Entscheidungen zu treffen. Und das alles möglichst effizient und präzise. Bei der Kreativität geht es genau in die andere Richtung. Losgelöst vom Bekannten, Offensichtlichen und Rationalen wollen wir Nützliches und Neues schaffen und umsetzen. Generativ bedeutet, die Kraft oder Funktion zu haben, etwas zu erzeugen, hervorzubringen, zu produzieren oder zu reproduzieren. Dieses „Etwas“ kann originell, neu und nützlich sein. Erst dann sind unsere definierten Anforderungen an Kreativität erfüllt. Um sich ein Urteil darüber bilden zu können, inwieweit ein generativer künstlicher Agent kreatives Potenzial besitzt, sich kreativ verhält und kreative Produkte hervorbringt, müssen wir seine Funktionsweise näher betrachten.

Das Generative adversarial network (GAN)

Ein GAN ist eine Architektur im Bereich des Deep Learnings. Mit Hilfe eines GANs können beispielsweise neue Bilder aus einer vorhandenen Bilddatenbank oder Musik aus einer Datenbank mit Liedern generiert werden.

Ein GAN besteht aus zwei Teilen. Der Diskriminator und der Generator. In der obenstehenden Abbildung sieht man unter „Real data“ reale Daten, beispielsweise Bilder von Hunden, die wir dem Diskriminator übergeben. Der Diskriminator entscheidet aufgrund seines Vorwissens, ob das Bild echt ist oder nicht. Je nachdem, ob das Urteil richtig oder falsch war, passt sich das Modell im Nachhinein an, lernt dazu und urteilt beim nächsten Bild eher richtig. Auf der anderen Seite haben wir einen Generator. Dieser erhält ein reales Bild und verändert es - fügt ein Rauschen hinzu - indem er zum Beispiel dem Hund einen Hut aufsetzt. Auch dieses Bild wird dem Diskriminator zur Bewertung übergeben. Wenn der Generator mit seinem modifizierten Bild die Echtheitsprüfung nicht besteht, passt er sein Modell an, um beim nächsten Mal die Realität besser zu imitieren. Ziel ist es, aus dem, was der Generator von der Realität kennt, etwas Neues zu erzeugen, das der Realität so nahe kommt, dass der Diskriminator es für echt hält. Es ist nicht das Ziel des Generators, etwas Neues oder Nützliches zu erzeugen. Ohne eine konkrete Anweisung kann er nicht wissen, was für uns nützlich ist.

Könnte eine GAN selbst Eidechsen und Pferde mit Flügeln in Regenbogenfarben erschaffen, nur weil es denkt: „Das gab’s noch nicht und das finden bestimmt alle total cool”? Wenn, dann nur durch Zufall. Jedes generierte Bild bleibt eine Antwort auf eine Aufgabenstellung und versucht, so nah wie möglich am gegebenen Kontext und an der Aufgabenstellung zu bleiben. Achtung subjektive Wahrnehmung: Um Ergebnisse zu erhalten, die sich weiter von der Realität entfernen, ist es hilfreich, Hinweise auf eine andere - nicht reale - Welt zu geben. Zum Beispiel „It is a steam punk world” oder „it is a fantasy world”.

Beim Menschen ist der kognitionswissenschaftliche Prozess, der der Kreativität beziehungsweise dem divergenten und konvergenten Denken zugrunde liegt, noch nicht vollständig erforscht. Kreatives Denken ist ein iterativer Prozess von spontaner Generierung und kontrollierter Ausarbeitung. Er ist eng mit dem Lernprozess verbunden.

Wichtige Aspekte sind

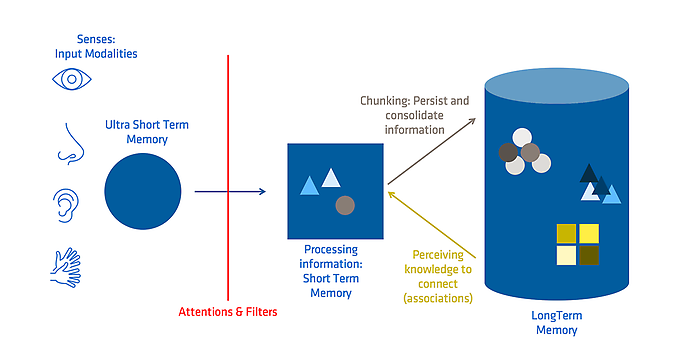

- Aufmerksamkeit: Die Fähigkeit, die auf uns einströmenden Informationen zu filtern, aufzunehmen und zu verarbeiten. Im Ultrakurzzeitgedächtnis (auch sensorisches Gedächtnis genannt) verweilen visuelle Informationen bis zu 0,5 Sekunden und auditive Informationen bis zu zwei Sekunden, bis entschieden wird, ob sie überhaupt weiter verarbeitet werden.

- Kurzzeit- oder Arbeitsgedächtnis: Hier können vier bis maximal neun „Informationshäppchen“ (Chunks) gleichzeitig gespeichert und weiterverarbeitet werden.

- Langzeitgedächtnis: Hier können wir Informationen für eine Sekunde oder ein ganzes Leben als Schema speichern.

Wenn wir auf neue relevante Informationen stoßen und uns entscheiden, diese weiter zu verarbeiten, ist dies immer mit einem Abruf von Wissen verbunden, das bereits im Langzeitgedächtnis vorhanden ist. Jede Informationsverarbeitung führt zu Veränderungen in bestehenden Schemata.

Doch welche Informationen aus dem Langzeitgedächtnis benötigen wir, um die neu gewonnenen Informationen später sinnvoll zu verknüpfen und abzulegen (Chunking)? Jeder von uns hat seine eigenen Schemata und sieht andere Zusammenhänge. Die Annahme, dass Vorstellungen in Form einfacher kognitiver Elemente miteinander verknüpft (gelernt) werden, wird als Assoziation bezeichnet.

„If you think about things the way someone else does, then you will never understand it as well as if you think about it your own way.”

Manjul Bhargava (Fields Medal Mathematics, 2014)

Assoziatives Denken ist ein mentaler Prozess, bei dem eine Idee, ein Gedanke oder ein Konzept mit einer anderen Idee oder einem anderen Konzept verbunden oder assoziiert wird, die oft scheinbar nichts miteinander zu tun haben. Je nach Kultur und Erfahrung haben Menschen mehr oder weniger ähnliche Denkmuster, und wir stellen oft ähnliche Assoziationen her. In einer Studie wurden beispielsweise Personen gebeten, eine Tierart mit Federn zu zeichnen. Die meisten Probanden neigten dazu, der Kreatur auch Flügel und einen Schnabel zu geben. Wir neigen zu „vorhersehbarer” Kreativität, bei der wir uns nicht weit von der Realität entfernen. Außerhalb eines kontextuellen Lösungsraumes zu suchen und daraus etwas Nützliches zu schaffen, ist kognitiv sehr aufwendig.

Mit Hilfe bestimmter Techniken und Denkweisen kann es uns gelingen, bestehende Kontexte und Vorstellungen zu durchbrechen, indem wir uns zwei widersprüchliche Konzepte gleichzeitig vorstellen oder darüber nachdenken. Einige Kreativitätstechniken werden im nächsten Teil vorgestellt.

Janusian Thinking ist zum Beispiel die Fähigkeit, aus zwei Gegensätzen etwas Neues und Wertvolles zu schaffen. Albert Einstein stellte sich zum Beispiel vor, dass ein Mensch, der von einem Dach fällt, gleichzeitig in (relativer) Ruhe und in Bewegung ist - eine Erkenntnis, die durch seine Allgemeine Relativitätstheorie erklärt wird. Dank unter anderem riesiger Wissensdatenbanken und semantischer Netze ist die Assoziationsfähigkeit generativer künstlicher Agenten beeindruckend. Schauen wir uns diese Fähigkeit genauer an.

RNNs, LSTM und Transformer

Recurrent Neural Networks werden verwendet, um große Textmengen in eine andere Sprache zu übersetzen. Dabei wird der Text Satz für Satz und Wort für Wort verarbeitet:

- Das Pferd frisst keinen Gurkensalat.

- Das Tier bevorzugt Karotten.

- Aber füttere es nicht mit Schokolade.

Schon im zweiten Satz finden wir das Pferd nicht mehr. Zum Glück wissen wir aus unserer Wissensdatenbank, dass ein Pferd ein Tier ist. Und wer ist „es“ im dritten Satz? Um diese Fragen später beantworten zu können, muss ein Kontext erhalten bleiben und von Prozessschritt zu Prozessschritt weitergegeben werden (ein Hidden State).

Unser Textkörper ist sehr klein. Wenn wir ein ganzes Buch übersetzen wollen, wächst der übertragene Hidden State mit jedem Schritt und wird mit der Zeit unberechenbar. Ähnlich wie Menschen im Arbeits- und Langzeitgedächtnis eine Information je nach Relevanz unterschiedlich lange als Kontext für den nächsten Prozess halten können, wurde das Long-Short Term Memory (LTSM) als eine Art RNN eingeführt. Informationen, die wir nur an den nächsten Prozess weitergeben, halten wir kurz (Hidden State), global relevante Informationen länger (Cell State). Aber auch das ist nicht optimal und kann insbesondere bei langen Texten fehlschlagen. Das sequentielle Abarbeiten von Texten unter Beibehaltung des Kontextes hat Nachteile. Selbst wenn wir es durch LTSM schaffen, nur das im Kontext zu halten, was wir für wichtig halten, wird der Kontext immer größer und es gehen möglicherweise notwendige Informationen verloren.

Als Lösung für dieses Problem haben Entwicklerinnen und Entwickler von Google 2017 ein Papier mit dem Titel „Attention is all you need” vorgelegt.

Aufmerksamkeit - das fehlende Element im Prozess. Wir Menschen lesen einen Text selten Wort für Wort. Wir behalten den Kontext im Auge und richten unsere Aufmerksamkeit auf das, was gerade relevant ist. Nicht jedes Wort ist gleich wichtig. Einige werden „überflogen”. Wir betrachten Informationen aus verschiedenen Blickwinkeln. Während der Mensch aufgrund der Begrenztheit des Arbeitsgedächtnisses nur eine maximale Anzahl von Informationsblöcken verarbeiten kann, ist der Transformer dank der mehrperspektivischen Aufmerksamkeit wesentlich schneller. Dies gibt dem Transformer die Möglichkeit, mehrere Beziehungen und Nuancen für jedes Wort zu kodieren. Laut Ashish Vaswani, Google Brain, wurden die Transformer übrigens so genannt, weil „Attention Net” zu langweilig gewesen wäre. Ein generativer künstlicher Agent versucht also, einerseits die wichtigsten Informationen zu erkennen und andererseits möglichst viele Kontextinformationen zu extrahieren, um uns durch entsprechende Assoziationen ein möglichst realistisches Ergebnis liefern zu können.

Nachdem wir nun oberflächlich die Funktionsweise kennen, wissen wir vom menschlichen Prozess, dass neue und möglicherweise nützliche Assoziationen - Ideen - durch das Abrufen vorhandener Informationen und das Verknüpfen neuer und vorhandener Informationsblöcke oder Schemata entstehen. Um originelle Verknüpfungen zu schaffen, müssen Informationen nicht nur abgerufen, sondern auch zuerst gefunden und in einen offensichtlichen Zusammenhang gebracht werden.

Die Worte „Das Pferd frisst keinen Gurkensalat” waren die ersten Worte, die durch ein Telefon gesprochen wurden. Philipp Reis war Lehrer in Hessen und baute für seine Schüler eine Ohrmuschel nach. Er hatte Erfolg. Gleichzeitig konnte der Apparat durch galvanischen Strom Töne aller Art in beliebiger Entfernung wiedergeben. Um zu beweisen, dass die gesprochenen Sätze auch wirklich am anderen Ende ankamen und nicht auswendig gelernt waren, wählte er für die Übertragung skurrile, spontan gesprochene Sätze. Aber so komisch ist der Satz gar nicht.

Das Ziel von Herrn Reis war es, ein Wort zu wählen, das semantisch weit von der Realität entfernt ist. Es sollte originell sein. Im Prinzip frisst ein Pferd Gemüse. Man müsste es ausprobieren, aber es ist nicht auszuschließen, dass ein Pferd bei mittlerem bis starkem Hunger ausnahmsweise zu Gurkensalat greift. Wenn ein generativer künstlicher Agent Text erzeugt, geht er ähnlich vor. Er reist durch den semantischen Raum, bis er etwas Passendes findet und den Satz vervollständigt. Um zu originellen und möglicherweise nützlichen Antworten zu gelangen, müssen wir weiter durch den semantischen Raum reisen. Dadurch erhöht sich die Anzahl der Alternativen, deren Brauchbarkeit bewertet werden muss.

Das Ziel eines generativen künstlichen Agenten ist aber nicht, uns eine möglichst originelle Antwort zu geben, sondern nahe an der Realität zu bleiben und „realistisch“ zu antworten. Auch im Fall von Reis ist man im semantischen Raum nicht weit gekommen.

Als wir ChatGPT-3 baten, den Satz „Pferde fressen nicht...“ zu vervollständigen, erhielten wir als Antwort „Gurkensalat“ mit der Biographie von Philipp Reis. Als wir nach Alternativen fragten, gab ChatGPT-3 „Hafer“, „Mais“ und „Weizen“ zurück. ChatGPT-3 ignorierte das „keine“ im Satz und gab uns dann die naheliegendsten Alternativen. Etwas passender war die Antwort bei unserem englischen Versuch „The horse eats no...“, wo uns ChatGPT-3 „hay that has not been thoroughly inspected for mold and contaminants” als Antwort gab. Eine sehr rationale Antwort. Nicht originell, aber nützlich. Als wir ChatGPT-3 nach „kreativeren“ Antworten fragten, erhielten wir „Sternenstaub“, „Mondlicht“ und „Regenbogen“. Dies zeigte, dass ChatGPT-3 die Aufforderung, sich „kreativ“ zu verhalten, als Aufforderung auffasste, sich weiter im semantischen Raum zu bewegen. Das konnte uns ChatGPT-3 auf die Frage „So when I ask you to give me a creative answer you travel further withing your semantic network?” bestätigen:

ChatGPT-3: „Yes, when you ask for a creative answer, I effectively „travel further" within my semantic network. This means I explore a wider range of nodes (concepts) and edges (relationships) to draw from more diverse and sometimes less directly related areas of knowledge.”

Menschen, die wir als kreativer wahrnehmen, haben oft flexiblere semantische Netzwerke. Zwischen den einzelnen Konzepten (nodes) gibt es viele Verbindungen (edges) und kurze Wege. Wie gut ihr selbst im assoziativen Denken seid, könnt ihr mit dem Remote Associate Test herausfinden. Hier bekommt ihr drei Begriffe (fish, rush, mine) und müsst den Begriff finden, der alle drei Begriffe verbindet (Lösung: gold => goldfish, goldrush, goldmine). Eine kostenlose Seite mit Beispielen zum Ausprobieren gibt es hier. Wir haben auch ChatGPT-3 getestet und sind dabei an unsere Grenzen gestoßen. Um es selbst auszuprobieren, empfehlen wir folgenden Prompt: „With which word can we combine these three words in a meaningful way? palm, shoe, house”.

Assoziationen sind relevant für divergentes Denken und Kreativität. Doch Assoziation ist nicht der einzige Weg, um kreative Ideen zu generieren. Weitere kognitive Prozesse sind:

- Generalisierung: Extrahieren gemeinsamer Merkmale aus spezifischen Beispielen, um eine allgemeine Regel oder ein Konzept zu bilden (etwa alle Vögel haben Federn).

- Analogien: Abbildung der Beziehungen zwischen Elementen aus zwei verschiedenen Bereichen, um Ähnlichkeiten hervorzuheben (etwa das Gehirn ist für den Menschen, was die CPU für den Computer ist).

- Abstraktion: Fokus auf spezifische Details, um sich auf die Kernprinzipien eines Konzepts zu konzentrieren.

Ein Beispiel für abstraktes Denken: Chamäleons, Tintenfische und Polarfüchse tarnen sich mit Hilfe ihrer Haut- oder Fellfarbe, um von ihren Feinden oder ihrer Beute nicht gesehen zu werden. Dieses Konzept können wir nun als abstraktes Wissen extrahieren und anwenden. Wir finden es heute beispielsweise als Tarnung im Militär wieder, wo es ebenfalls dazu dient, weder vom Feind noch von der Beute entdeckt zu werden.

Generalisierung, Abstraktion und Analogien werden derzeit intensiv von der Wissenschaft untersucht. Der Markt für generative KI ist dabei, potenzielle Lösungen zu erproben, wie beispielsweise Structure-Mapping Engines (SME). Im Bereich der Analogien gibt es bereits einige Durchbrüche, die unter dem Begriff „Domain Transfer“ bekannt sind. Es scheint jedoch, dass wir noch weit von Technologien entfernt sind, die menschenähnliche Fähigkeiten in Bezug auf abstraktes Denken haben. Auch wenn ChatGPT-3 von seinen Fähigkeiten überzeugt ist. Wer mehr darüber erfahren möchte, dem sei als Einstieg diese wissenschaftliche Arbeit des Santa Fe Institute empfohlen.

Ihr möchtet gern mehr über spannende Themen aus der adesso-Welt erfahren? Dann werft auch einen Blick in unsere bisher erschienenen Blog-Beiträge.

Auch interessant: