30. Juli 2024 von Sascha Windisch und Immo Weber

Effizienz durch Innovation: 10 Grundsätze für den Einsatz Generativer KI in der öffentlichen Verwaltung

Seit der Einführung von ChatGPT Ende 2023 hat die generative KI, insbesondere die sogenannten Large Language Models (LLM), die IT-Welt im Sturm erobert. Ob als Chat-Assistent, zum Zusammenfassen von Texten, zum Extrahieren von (Domänen-)Wissen oder als Programmierhilfe - die Möglichkeiten von LLMs scheinen unendlich und täglich kommen neue Anwendungsfälle hinzu. Kein Wunder also, dass auch die öffentliche Verwaltung in jüngster Zeit das enorme Potenzial der generativen KI erkannt hat und mit am Tisch sitzen möchte. In diesem Blog-Beitrag werden die Chancen, aber auch die spezifischen Herausforderungen und Risiken des Einsatzes generativer KI in der öffentlichen Verwaltung anhand von zehn zentralen Thesen näher beleuchtet.

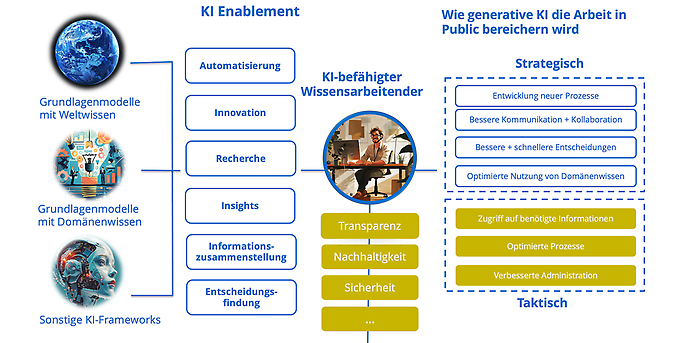

Abbildung 1: Anforderungen an den Einsatz generativer KI in der öffentlichen Verwaltung.

1. Generative KI bietet vielfältige Potentiale in der öffentlichen Verwaltung

Gerade für den Public-Bereich ergeben sich durch den Einsatz von generativer KI große Einsatzpotentiale, die vor allem auf Effizienzsteigerungen und Bürokratieabbau abzielen, beides Kernanliegen der aktuellen Bundesregierung. Neben der Möglichkeit der KI-gestützten Audio-, Bild- und Videogenerierung ist es vor allem die Textgenerierung mittels großer Sprachmodelle, die im öffentlichen Bereich derzeit am häufigsten eingesetzt wird.

Mitte 2023 hat das Innovationslabor Baden-Württemberg in Kooperation mit dem deutschen LLM-Hoffnungsträger Aleph Alpha mit dem Projekt „F13“ eine Blaupause für den prototypischen Einsatz von generativer KI in der öffentlichen Verwaltung umgesetzt. Das Projekt bietet verschiedene Funktionen, darunter

- 1) die Zusammenfassung von Texten,

- 2) die Verschlagwortung von Texten,

- 3) die Überführung von Texten in Templateformate (Kabinettsvorlagen),

- 4) die Rechercheassistenz für die Aufbereitung und Abfrage großer Mengen intern vorhandener Informationen sowie

- 5) die Fließtextgenerierung für die Zusammenführung von Einzeldokumenten und Texten. Auch wenn es sich hierbei nur um einen kleinen Ausschnitt aus der Funktionsvielfalt handelt, zeigt dieser Prototyp sehr deutlich die Möglichkeiten dieser neuen Technologie und gibt Interessierten einen ersten Anhaltspunkt, in welche Richtung eine Unterstützung durch generative KI gehen könnte.

Generell kann der Einsatz von LLM grob in drei übergeordnete Anwendungsszenarien unterteilt werden:

- I. Domänen-Knowledge-Agents (Beispiel: F13-Funktion 4)

- II. Dokumentverarbeitung (Beispiel: F13 Funktionen 2 und 3)

- III. Textmanipulation und -generierung (Beispiel: F13 Funktionen 1 und 5)

Eine inzwischen bewährte Systemarchitektur für I) ist die sogenannte „Retrieval Augmented Generation“. Damit ist es möglich, das vorhandene Wissen eines LLM mit etwa lokal vorhandenem Domänenwissen der öffentlichen Verwaltung anzureichern. Mehr darüber findet ihr im Blog-Beitrag zum Thema „Retrieval Augmented Generation: LLM auf Steroiden “.

2. Anwendungsfälle für generative KI in Public sollten gescoped werden

In den allermeisten Fällen ist jedoch ein dediziertes „Scoping“ und eine Eingrenzung möglicher Use Cases, in der Regel im Rahmen eines Workshops, der erste sinnvolle und auch notwendige Schritt. Dabei sollten nicht nur Potenziale aufgezeigt, sondern auch Risiken oder Alternativen zur KI diskutiert werden. Denn nur weil eine generative KI ein bestimmtes Problem lösen kann, heißt das nicht, dass dies auch der optimale Weg ist.

In vielen Fällen wird die Umsetzung eines (generativen) KI-Projekts als innovative Lösung zur Lösung komplexer Probleme oder zur Optimierung von Prozessen gesehen. Bevor man sich jedoch voll und ganz auf ein (generatives) KI-Projekt einlässt, ist es wichtig zu prüfen, ob es wirklich notwendig ist. Es gibt Situationen, in denen herkömmliche Methoden oder bereits vorhandene Technologien ebenso effektiv sein können, ohne den Aufwand und die Ressourcen eines KI-Projekts zu erfordern.

Zunächst sollten die spezifischen Anforderungen und Ziele des Projekts genau analysiert werden. Ist die Komplexität der Aufgabenstellung so hoch, dass herkömmliche Methoden an ihre Grenzen stoßen? Gibt es bereits bestehende Technologien oder Verfahren, die mit geringen Anpassungen die gewünschten Ergebnisse liefern könnten? Eine gründliche Bewertung dieser Aspekte kann dabei helfen, festzustellen, ob ein KI-Projekt die beste Option ist.

Darüber hinaus ist es wichtig, die Kosten und den Zeitaufwand für die Entwicklung und Implementierung einer KI-Lösung zu berücksichtigen. Häufig können alternative Lösungen schneller und kostengünstiger umgesetzt werden, insbesondere wenn die für eine KI-Anwendung benötigten Daten nicht verfügbar oder von schlechter Qualität sind.

Letztendlich sollte die Entscheidung für oder gegen ein (generatives) KI-Projekt sorgfältig abgewogen werden, wobei auch alternative Ansätze in Betracht gezogen werden sollten. Eine gründliche Analyse der Anforderungen, Kosten und verfügbaren Ressourcen ist entscheidend, um sicherzustellen, dass die gewählte Lösung die bestmöglichen Ergebnisse liefert.

3. Generative KI in Public erfordert oft lokale Lösungen

Jede Branche hat ihre eigenen Anforderungen und Herausforderungen, wenn es um die Implementierung von (generativer) KI geht. Dies gilt auch und insbesondere für die öffentliche Verwaltung. Ein wesentlicher Grund hierfür ist häufig die Verwendung personenbezogener oder anderer sicherheitskritischer Daten, die entsprechend hohe Sicherheitsanforderungen an eine mögliche (generative) KI-Lösung stellen. Während in anderen Bereichen der Branchenprimus OpenAI oft die beste (aber auch teuerste) Wahl für eine Implementierung ist, ist dies in öffentlichen Kontexten keine oder nur in Ausnahmefällen eine Option. Dies liegt unter anderem daran, dass OpenAI als US-amerikanisches Unternehmen der US-amerikanischen Rechtsprechung unterliegt. Dementsprechend ermöglicht es amerikanischen Sicherheitsbehörden durch die Auslegung des sogenannten „Patriot Act“ oder „Cloud Act“ u.a. den Zugriff auf Nutzerdaten. Zwar gibt es mittlerweile die Möglichkeit, OpenAI-Modelle auf Microsoft-Servern in Europa in Azure zu instanziieren, jedoch ist auch dies keine optimale Lösung für sicherheitskritische Anwendungsfälle in der öffentlichen Verwaltung. In den allermeisten Fällen ist daher der lokale Betrieb der Systeme („on-premise“) eine wesentliche Anforderung an eine mögliche LLM-Lösung.

4. Generative KI-Lösungen in Public müssen individuell entwickelt werden

Für den lokalen Betrieb kommen derzeit im Wesentlichen zwei Alternativen in Frage: 1. die kommerziellen LLM-Lösungen der Heidelberger Firma Aleph Alpha („Luminous“) oder 2. der Einsatz einer Open-Source-Lösung beispielsweise auf Basis von Facebooks „Llama2“ oder der Modellreihe von Mistral AI.

Welches Modell genau eingesetzt beziehungsweise getestet werden soll, muss je nach Anwendungsfall individuell evaluiert werden. Grundsätzlich ist es jedoch nicht ausreichend, sich „nur“ auf das Sprachmodell zu konzentrieren. Das LLM muss für jeden Anwendungsfall individuell in ein spezifisch zu entwickelndes KI-Framework eingebettet werden. Man spricht daher auch von „KI-Systemen“ und meint damit neben dem eigentlichen Sprachmodell weitere relevante Komponenten wie (Vektor-)Datenbanken, Benutzeroberflächen, Schnittstellen etc. Es gibt nicht DIE Lösung, die per „Plug & Play“ eingesetzt werden kann. Jede Lösung erfordert eine individuelle Entwicklung.

5. Generative KI in Public muss verprobt werden

KI-Projekte und traditionelle Projekte verfolgen grundsätzlich zwei unterschiedliche Ansätze zur Umsetzung der Anforderungen, wie in der folgenden Abbildung dargestellt.

Abbildung 2: Unterschiede in der Entwicklung traditioneller Softwareprojekte und KI-Projekte.

Bei traditionellen Projekten erfolgt die Realisierung auf der Grundlage fester Regeln und Algorithmen. Die Entwicklerin oder der Entwickler schreibt den Code, der die gewünschte Funktionalität direkt implementiert. Der Code wird in der Regel von Hand geschrieben und ist explizit auf die spezifische Aufgabe oder Anwendung zugeschnitten. Änderungen oder Anpassungen erfordern in der Regel eine direkte Änderung des Codes durch die Entwicklerin oder den Entwickler. Die Entwicklung ist gut planbar und kann beispielsweise nach dem Wasserfallprinzip erfolgen.

KI hingegen ermöglicht es einem System, aus Daten zu lernen, anstatt explizit programmiert zu werden. Das System lernt Muster und Zusammenhänge in den Daten, um Vorhersagen zu machen oder Entscheidungen zu treffen, ohne dass der Entwickler alle Regeln explizit festlegen muss. Anstatt direkte Anweisungen zu geben, wie ein Problem zu lösen ist, werden Trainingsdaten verwendet, um das Modell zu trainieren, damit es Muster und Beziehungen erkennt. Das trainierte Modell wird dann verwendet, um Vorhersagen für neue Daten zu treffen. Es kann auch iterativ verbessert werden, indem es mit neuen Daten weiter trainiert wird.

Insgesamt liegt der Hauptunterschied zwischen den beiden Ansätzen in der Art und Weise, wie Probleme angegangen werden. Traditionelle Projekte verwenden explizite Anweisungen und Regeln, während KI datenbasiert ist und das System lernt, Aufgaben auszuführen, ohne explizit programmiert zu werden.

Insbesondere LLMs sind aufgrund ihrer Komplexität und ihres probabilistischen bzw. nicht-deterministischen Charakters schwer einzuschätzen und in ihren Antworten nur sehr begrenzt vorhersagbar. Umso wichtiger ist es, eine generative KI-Lösung zunächst im Rahmen eines PoC („Proof of Concept“) zu erproben. In der Regel werden daher im Rahmen eines agilen Entwicklungsansatzes zunächst verschiedene Modelle, Parameter- und Promptkombinationen gegeneinander getestet und evaluiert.

6. Generative KI in Public ist nicht günstig

Ein weiterer wichtiger Punkt beim Einsatz einer „On-Premise“-Lösung sind die Kosten. Neben den reinen Lizenzkosten (bei Verwendung eines kommerziellen LLM ca. 0,02-0,06 €/1000 Wörter) muss eine ausreichend leistungsfähige Hardwareinfrastruktur vorhanden sein oder ggf. angeschafft werden. Neben den Betriebs- und Serverkosten sind dedizierte Grafikprozessoren (GPUs) die Hauptkostentreiber (ca. 12000-20000 € pro Einheit). Dementsprechend ist für die meisten Anwendungsfälle mit Kosten im niedrigen bis mittleren sechsstelligen Bereich zu rechnen.

7. Generative KI in Public sollte nachhaltig und nachnutzbar entwickelt werden

Generative KI birgt zwar ein hohes Einsatzpotenzial in der öffentlichen Verwaltung. Damit dieses aber auch langfristig genutzt werden kann, sollten entsprechende KI-Systeme nachhaltig und nachnutzbar entwickelt werden. Dies bedeutet, dass bei der Entwicklung darauf geachtet werden sollte, Systeme zu schaffen, die nicht nur zum aktuellen Zeitpunkt nützlich sind, sondern auch in Zukunft angepasst und weiterentwickelt werden können. Nachhaltigkeit umfasst dabei auch den verantwortungsvollen Umgang mit Ressourcen und die Minimierung von Umweltauswirkungen. Gerade komplexe KI-Anwendungen sind extrem ressourcenintensiv, weshalb es umso wichtiger ist, generative KI möglichst energieeffizient umzusetzen. Unter Beachtung dieser Prinzipien können generative KI-Systeme im öffentlichen Sektor so entwickelt werden, dass sie einen nachhaltigen Mehrwert bieten und gleichzeitig ethischen und ökologischen Standards genügen.

8. Generative KI in Public sollte interoperabel sein

In vielen Kontexten der öffentlichen Verwaltung spielt auch die Interoperabilität der generativen KI eine wichtige Rolle. Interoperabilität stellt sicher, dass KI-Systeme im Idealfall nahtlos mit bestehenden digitalen Infrastrukturen, Datenbanken oder Anwendungen in verschiedenen Behörden interagieren können. Dies ist unter anderem wichtig, damit Daten siloübergreifend genutzt und Dienste integriert werden können. Entsprechend müssen Systemgrenzen und Schnittstellen von KI-Systemen von Anfang an mitgedacht werden. Der Mehraufwand lohnt sich, da generative KI-Lösungen im Idealfall über Behördengrenzen hinweg skalierbar sind und die öffentliche Verwaltung dadurch deutlich agiler gestaltet werden kann.

9. Generative KI in Public sollte nachvollziehbar sein

Gerade wenn generative KI in anwendungs- und sicherheitskritischen Kontexten eingesetzt werden soll, ist es wichtig, die Entscheidungen der KI nachvollziehen zu können. Während bei konventionellen KI-Systemen Transparenz zum Beispiel durch die Verwendung sogenannter White-Box-Modelle gewährleistet werden kann, ist dies bei generativer KI, die in der Regel durch komplexe Black-Box-Modelle implementiert wird, nicht möglich. Transparenz kann jedoch auf andere Weise ermöglicht werden. Eine große Gefahr bei LLMs ist, dass Antworten halluziniert werden, d.h. falsche Fakten ohne Grundlage als wahr ausgegeben werden. Dies kann verhindert oder zumindest nachvollziehbar gemacht werden, indem KI-Systeme so implementiert werden, dass LLMs im Zweifelsfall statt auf vortrainiertes Weltwissen nur auf lokales Domänenwissen zugreifen und die Quellen für Aussagen mit ausgeben. Auf diese Weise kann der Anwender die Aussagen der KI im Zweifelsfall überprüfen.

10. Generative KI in Public ist (nur) ein Werkzeug. Am Ende entscheidet der Mensch.

Ein wesentlicher Vorteil der generativen KI ist die Möglichkeit, Prozesse zu automatisieren und im Kontext der öffentlichen Verwaltung unter anderem Bürokratie abzubauen. Auch wenn solche KI-Systeme sehr zuverlässig sein können bzw. sind, sollten und dürfen sie insbesondere in sicherheitskritischen Anwendungsszenarien niemals vollständig automatisierte Entscheidungen treffen. Gemäß dem sogenannten „Human-in-the-Loop“-Prinzip kann generative KI als Werkzeug hier nur unterstützend wirken. Es liegt in der Verantwortung des menschlichen Anwenders, die Unterstützung der KI am Ende abzunehmen und die finalen Entscheidungen zu treffen. Dies führt zwangsläufig auch dazu, dass die zumindest in der Privatwirtschaft nicht ganz unbegründete Befürchtung, KI könne Arbeitsplätze vernichten, zumindest in der öffentlichen Verwaltung bislang nicht gerechtfertigt ist.

Abbildung 3: Unterstützung durch Befähigung. Generative KI als Werkzeug.

Generative KI in Public ist herausfordernd, aber lohnenswert

Zusammenfassend bietet generative KI in der öffentlichen Verwaltung wie auch in anderen Bereichen vielfältige Potenziale, um Prozesse effizienter zu gestalten. Allerdings gehen mit den hohen Anforderungen an Sicherheit und Transparenz im Public auch besondere Herausforderungen einher, die von Anfang an berücksichtigt werden müssen. Umso wichtiger ist eine frühzeitige Planung und gegebenenfalls Beratung, um alle Chancen und Risiken des Einsatzes generativer KI in der öffentlichen Verwaltung gegeneinander abzuwägen.

Ihr möchtet gern mehr über spannende Themen aus der adesso-Welt erfahren? Dann werft auch einen Blick in unsere bisher erschienenen Blog-Beiträge.

KI im Public-Sektor

Anwendungsmöglichkeiten im Behördenalltag

Entdeckt, wie Künstliche Intelligenz die öffentliche Verwaltung revolutioniert und erfahrt, wie innovative KI-Lösungen Prozesse optimieren, den Bürgerservice verbessern und die Zukunft der Verwaltung gestalten. Werdet Teil der digitalen Transformation - jetzt informieren und profitieren!